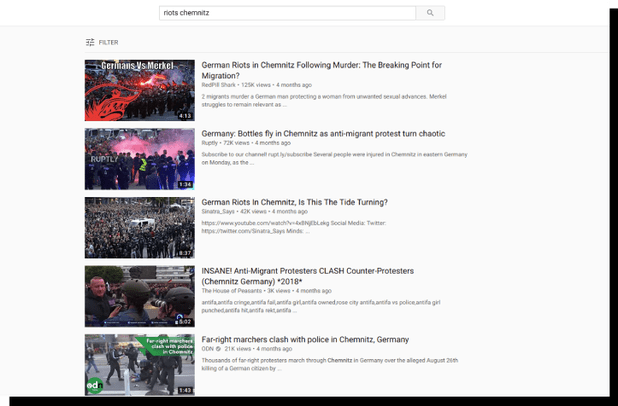

Stel je bent voor een werkstuk op zoek naar informatie over de rellen in het Oost-Duitse Chemnitz in de zomer van 2018, die vooral in het nieuws kwamen door neonazi’s onder de demonstranten. Je gaat, zoals zoveel jongeren die op zoek zijn naar informatie, naar YouTube en vult ‘riots chemnitz’ in de zoekbalk in. Zijn de video’s die je terugkrijgt enigszins objectief van toon? Geven ze een waarheidsgetrouw beeld van wat er deze zomer in de Duitse stad is gebeurd?

Dit is wat YouTube onlangs voor ons relevant achtte:

Bovenaan staat een video van Red Pill Shark, een kanaal met 55.204 abonnees. Dit kanaal behoort tot de alt-right, een van oorsprong Amerikaanse beweging die draait om wit superioriteitsdenken, waarbinnen ook het antisemitisme welig tiert.

De video’s van Red Pill Shark ageren tegen de EU, immigratie, George Soros, transgenders, links en spreken vol lof over Donald Trump, Jair Bolsonaro, Victor Orbán en Rusland. Red Pill Sharks video over de rellen in Chemnitz is één grote aanklacht tegen het immigratiebeleid van Angela Merkel en is 125.000 keer bekeken.

Daaronder staan video’s van:

- Ruptly, een kanaal van de tv-zender Russia Today;

- Sinatra_Says, een kanaal dat zich vooral tegen zogenoemde social justice warriors richt, progressieve activisten;

- The House of Peasants, eveneens een alt-right-kanaal;

- Op nummer 9 in de lijst komen we een video van Red Ice TV tegen, een kanaal dat onlangs een tweede officiële waarschuwing heeft gekregen van YouTube (bij de derde wordt het offline gehaald). De video’s van Red Ice TV gaan vooral over de vele vermeende bedreigingen voor het ‘witte ras’, waarvoor de schuld geregeld bij een links-Joodse kongsi wordt gelegd. In het verleden verzorgde Red Ice de live-registratie van de Erkenbrand-conferenties. Erkenbrand, dat zichzelf een ‘studiegenootschap’ noemt, is in Nederland de belangrijkste representant van de alt-right.

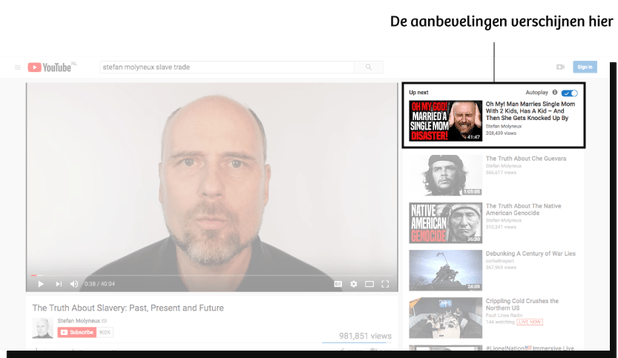

Wellicht dat dit aanbod een voorzichtige interesse wekt. Het zijn immers beelden die je misschien niet hebt meegekregen in reguliere media. De sensationele omschrijving van de gebeurtenissen in Chemnitz intrigeert ook. Dus is het niet vreemd dat je op het filmpje klikt van Red Ice TV.

Terwijl het filmpje loopt, verschijnen aan de rechterkant van het scherm aanbevelingen voor andere clips. Daartussen staat nog een video van Red Ice TV, met de titel They Want You Dead White Man. Daaronder wordt ook een video van PragerU aanbevolen: The Suicide of Europe.

Je kunt afhaken en het voor gezien houden. Maar YouTube zelf weet hoe belangrijk deze aanbevelingen zijn. Uit eigen onderzoek is namelijk gebleken dat meer dan 70 procent van de tijd die mensen aan YouTube besteden voortkomt uit een aanbeveling door een algoritme, een geavanceerd computerprogramma. Verreweg de meeste mensen kijken dus naar video’s die YouTube zelf heeft voorgesteld.

YouTube, de grote radicaliseringsmachine

Dat je dankzij de aanbevelingen van YouTube alsmaar verder kunt verdwalen in een woud van filmpjes over ‘witte genocide’, ‘maatschappijvernietigende’ feministen, moslims, Joden en cultureel marxisten, is volgens een groeiende groep onderzoekers, publicisten en journalisten een probleem dat meer aandacht verdient. Dat vonden ook de Volkskrant en De Correspondent, die besloten samen diepgravend onderzoek naar YouTube te doen.

Waar sociale media als Facebook en Twitter inmiddels felle kritiek krijgen vanwege de verspreiding van nepnieuws en haatberichten, blijft YouTube grotendeels buiten schot. Terwijl YouTube in Nederland en veel andere landen onder jongeren een van de belangrijkste sociale media is.

Die tunnel van aanbevelingen waar YouTube’s algoritme je in leidt, wordt inmiddels beschreven als een vorm van ‘radicalisering’ die kijkers vooral naar de extreemrechtse kant van het politieke spectrum trekt. De invloedrijke technologiesocioloog Zeynep Tufekci noemt YouTube daarom ‘de grote ‘radicaliseringmachine’. Zij staat zeker niet alleen in haar kritiek.

In de loop van 2017 treedt Guillaume Chaslot, een oud-medewerker van YouTube, naar buiten met harde kritiek op zijn voormalige werkgever. In maart dat jaar publiceerde hij een artikel over de aanbevelingen die automatisch op je scherm verschenen. Hij had voorafgaand aan de Amerikaanse presidentsverkiezingen gezocht naar Hillary Clinton en Donald Trump. Wie die zoektermen ook intikte, in vier van de vijf gevallen beval YouTube pro-Trump-filmpjes aan. Zoekopdrachten naar Hillary Clinton leverden meestal aanbevelingen voor anti-Clinton filmpjes op.

In september van dat jaar publiceren twee Duitse communicatiewetenschappers een studie naar de aanbevelingen die kijkers krijgen als ze video’s van de rechtspopulistische Alternative für Deutschland (AfD) bekijken. Die aanbevelingen leidden kijkers, aldus de onderzoekers, al snel naar video’s van meer extreme politieke groeperingen, zoals de NPD en de Identitaire beweging. Zo dient zich bijvoorbeeld een gelikt en opzwepend promotiefilmpje aan om je bij de extreemrechtse identitaire beweging aan te sluiten, de ‘snelst groeiende patriottische jeugdbeweging van Europa’.

Kijkers vallen in een algoritmisch rabbit hole van radicale en extremistische content waar ze niet snel meer uitkomen

Recenter heeft The New York Times over de resultaten van een klein onderzoek van Ray Serrato geschreven, een Berlijnse socialemedia-analist die ook voor VN-organisaties werkt. Serrato zocht naar alle YouTube-filmpjes over Chemnitz die in 2018 online waren gegaan en keek vervolgens welke video’s werden aanbevolen.

Zijn conclusie: als kijker kom je al snel terecht bij extreme videos. En als je eenmaal dat soort video’s aangeboden krijgt, blijven ze maar terugkomen in je aanbevelingen. Kijkers vallen in een algoritmisch rabbit hole van radicale en extremistische content waar ze niet zo snel meer uitkomen.

Maar hoe werkt dat dan precies met die aanbevelingen? Hoe zorgt de technologie van het platform ervoor dat je als kijker uiteindelijk terechtkomt bij video’s over ras en IQ en complottheorieën over een Joodse samenzwering?

Om hier antwoord op te geven, moeten we met een simpele vraag beginnen:

Wat is YouTube eigenlijk?

Het simpele antwoord is: het grootste videoplatform ter wereld dat 1,9 miljard gebruikers heeft. Iedere dag wordt er voor 1 miljard uur aan video’s bekeken en iedere minuut 400 uur aan video geüpload.

YouTube is ook de op een na grootste zoekmachine ter wereld: het moet alleen Google Search voor zich dulden. Een tiener die een werkstuk over de rellen in Chemnitz maakt, gebruikt hoogstwaarschijnlijk YouTube als zoekmachine.

En: YouTube is ook een van de belangrijkste sociale media voor jongeren.

Er is ook een ingewikkelder, maar een voor dit artikel relevanter antwoord op de vraag wat YouTube is. Die luidt: YouTube is een alternatief mediaplatform dat video’s aanbiedt die zorgvuldig geselecteerd zijn om gebruikers zo lang mogelijk aan het scherm gekluisterd te houden.

Achter die zorgvuldige selectie gaat complexe softwaretechniek schuil, waar we later in deze explainer dieper op in zullen gaan. Voor nu is het belangrijk om te weten dat YouTube zo is ingesteld dat het onze ‘niche’ – iets dat onze speciale aandacht heeft – probeert te achterhalen. Is YouTube daar eenmaal in geslaagd, dan biedt het ons oneindig veel video’s aan uit die niche.

YouTube is het grootste videoplatform, dus hoezo niche?

Wie van vogelen houdt, vindt op YouTube duizenden video’s over de zangkwaliteiten van allerlei vogels wereldwijd. Wil je je make-upvaardigheden aanscherpen? Op YouTube staat een heel leger aan beautyvloggers paraat om je dat te leren. Willen je kinderen graag de hele dag pranks kijken? De voorraad video’s raakt nooit op.

Je kunt het zo gek niet bedenken of voor iedere niche zijn er talloze video’s op YouTube te vinden die je niet snel in de reguliere media aantreft. YouTube is dus een alternatief mediaplatform, voor makers en kijkers die hun specifieke obsessie niet zo snel zullen aantreffen bij reguliere media. In ieder geval niet op die gedetailleerde en specialistische manier die je op YouTube tegenkomt.

Daarom is YouTube ook zo’n vergaarbak van zoveel maffe en zorgwekkende dingen.

Video’s dat de aarde plat is en niet rond? Daar zijn er een hoop van. Video’s die zouden bewijzen dat de Clintons deel uitmaken van een pedofiel genootschap dat kinderen in de kelder van een pizzarestaurant misbruikt en vermoordt? Die zijn nog steeds te vinden.

Video’s die betogen dat zwarte mensen een lager IQ hebben dan witte? Daar zijn hele kanalen aan gewijd. Video’s die mannen oproepen tot een celibatair bestaan omdat vrouwen onbetrouwbare ‘graaiende hoeren’ zouden zijn? Ook hier kun je je dagen, weken, maanden mee vullen.

Goed, je hebt rare niches, nou en?

Die niches zijn wat YouTube zo leuk, fascinerend en verrassend maakt, waarom je er altijd iets nieuws kunt ontdekken. Die niches kunnen er echter ook toe leiden dat je bij eenzijdige en extreme video’s terechtkomt. Dat geldt vreemd genoeg vooral voor onderwerpen waar juist grote consensus over (lijkt) te bestaan.

Neem de relatie tussen ras en IQ. De wetenschappelijke consensus is dat biologisch gezien ras niet bestaat. Er is voor de meeste mensen dan ook geen enkele reden om daar video’s over te maken. Waarom zou je? Het is daarom niet verwonderlijk dat van de vele video’s die je wel over dit onderwerp kunt vinden, verreweg de meeste betogen dat zwarte mensen over het algemeen een lager IQ hebben dan witte. Kortom: als je op YouTube een ogenschijnlijk neutrale zoektocht zou doen naar ‘ras en IQ’ beland je automatisch in het extremistische discours. Een ander discours is er namelijk niet.

Wat je ook niet op YouTube zult aantreffen: video’s die betogen dat de aarde wel rond is, dat de Clintons geen pedofielen zijn en dat vrouwen er niet continu op uit zijn je te ontdoen van je geld, mannelijke trots en waardigheid.

Met andere woorden: het aanbod van video’s is al scheef. Dat de aanbevelingen je daar dan naartoe leiden, is dan ook niet verwonderlijk.

Oké, duidelijk, dat zijn de niches. Hoe kom je zo makkelijk bij extreme video’s uit?

Met die vraag kloppen we aan bij Bernhard Rieder, universitair hoofddocent New Media and Digital Culture aan de Universiteit van Amsterdam. Met twee collega’s doet hij onderzoek naar hoe de technische infrastructuur van YouTube bepaalt wat wij aangeboden en te zien krijgen.

Het zal YouTube worst zijn of het een video aanbeveelt waarin Sylvana Simons voor ‘zwart aapje’ wordt uitgemaakt

YouTube neemt meestal niet op basis van inhoud een besluit of het je een video aanbeveelt, zoals media zouden doen. Als je naar WNL kijkt, hoef je geen programma te verwachten dat de zegeningen van veganisme bezingt en bij de VPRO zul je niet snel Temptation Island zien. Voor YouTube is alle content gelijk. Het vindt de videoclip DNA van de populaire rapper Kendrick Lamar net zo relevant als de videoclip White DNA is An ‘Abomination’ van Red Ice TV, waarin de ‘demonisering’ van het witte ras wordt gehekeld. Beide video’s kunnen naast elkaar opduiken in de zoekresultaten en aanbevelingen.

Maar juist die neutrale houding van YouTube is problematisch. Bernhard Rieder geeft het voorbeeld van twee zoektermen: ‘hamster’ en ‘Jood’. Deze zoektermen worden door YouTube hetzelfde behandeld, maar hebben een hele andere lading.

Een video over ‘Jood’ kan gaan over cultuur, maar ook over de Holocaust, of juist over Holocaustontkenning. Rieder: ‘Een term als "Jood" heeft een gevoelige geschiedenis. "Hamster" totaal niet en dan maakt het niets uit wat voor aanbevelingen we terugkrijgen.’

Met ieder onderwerp word je verder een niche ingeduwd omdat het vermoeden bestaat dat je daar geïnteresseerd in bent. Vaak doet het algoritme ook precies wat we willen: nieuwe content ontdekken. Maar er zijn situaties waarin je dat liever niet wil, waarin je wel een oordeel wil laten meewegen in wat mensen te zien krijgen. Bij maatschappelijke en politieke thema’s bijvoorbeeld, waarin gekker, maffer, extremer wél moreel problematisch kan zijn.

Kortom: de morele afweging, die veel media dag in dag uit maken bij de selectie van hun onderwerpen, ontbreekt. Het algoritme is waardevrij, ook wanneer het onderwerp zo gevoelig is dat het om een waardeoordeel vraagt.

Maar leiden die algoritmes je een bepaalde richting uit?

Dat er een ontwikkeling zit in de aanbevelingen die je krijgt, wordt wel duidelijk als je een tijdje intensief naar iets specifieks zoekt en je je aanbevelingen in de gaten houdt.

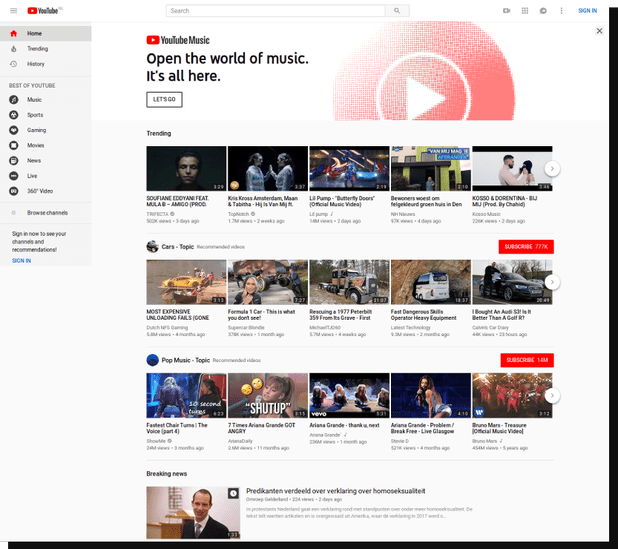

Tijdens ons onderzoek naar radicalisering op YouTube ervoeren we hoe snel deze aanbevelingen kunnen veranderen en je een tunnel kunnen induwen. We begonnen met een nieuw gebruikersaccount. Onze startpagina op YouTube zag er toen zo uit.

Er is nog niets gepersonaliseerd. De aanbevelingen bestaan uit trending video’s, auto’s, muziek, nieuws, satire. Kortom, nogal generieke content.

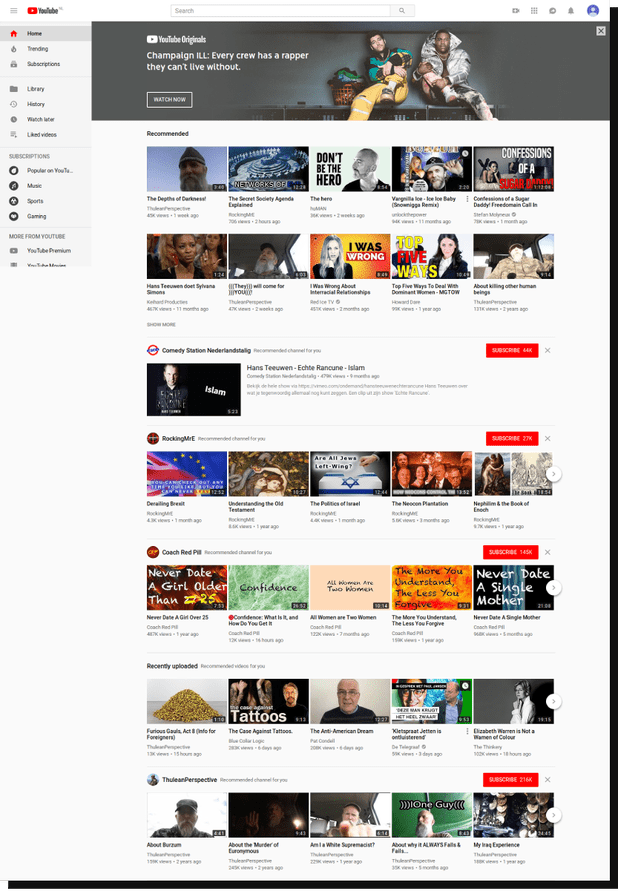

Na drie dagen onderzoek naar enkele extreemrechtse vloggers heeft onze startpagina op YouTube een ware gedaanteverwisseling ondergaan. Dit zijn de video’s waarvan het algoritme van YouTube nu denkt dat we ze graag willen zien.

We zien hier:

- Video’s van pickup artists en antifeministen.

- Clips van het extreemrechtse ThuleanPerspective en het Zweeds-Amerikaanse Red Ice TV. Van beide hebben we video’s bekeken, dus blijkbaar denkt YouTube dat we hier meer van willen zien.

- Een inhoudelijk negatieve video over Sylvana Simons. Over haar hebben we geen video’s bekeken, dus het is gek dat ze in onze aanbevelingen opduikt. En het is de eerste echte Nederlandse content die wordt aanbevolen.

- Het kanaal van Rocking MrE. Zijn video’s gaan over de zegeningen van nationalisme en religie, en zijn anti-Joods en antifeministisch.

- En vreemd genoeg het entertainmentkanaal Dutchtuber, waar we nog nooit iets van gezien hebben. Blijkbaar denkt YouTube dat we dit kunnen waarderen.

Let wel, ons kijkgedrag via dit account is niet normaal, in die zin dat we bewust heel extreme dingen hebben gezocht, die filmpjes vaak helemaal uitkeken en weinig andere video’s bekeken (zoals entertainment). Bij gewoon gebruik zul je wellicht minder snel in zo’n extreme tunnel worden geduwd, maar het blijft verrassend hoe weinig ander, in dit geval niet-extreem, aanbod er overblijft.

Achter deze verschuiving van aanbod gaan meerdere algoritmes schuil. Het ene handelt bijvoorbeeld de zoekvragen af. Het andere voert berekeningen uit op de achtergrond om uit miljoenen video’s een voorselectie van aanbevelingen te maken. En weer een ander kiest daaruit weer een aantal video’s om er een rangschikking van te maken, speciaal voor jou.

Zijn er meerdere soorten aanbevelingen?

Ja, en dat maakt het uitpluizen van hoe aanbevelingen werken een stuk ingewikkelder.

Zo zijn er zeker vier soorten aanbevelingen die YouTube doet.

De eerste is de persoonlijke aanbeveling. Die zie je als je YouTube opent. Het is een mix van oude en recente filmpjes. Daaronder zie je verse content die net is geüpload en op jou toegespitst is aan de hand van jouw eerdere kijkgedrag.

Daaronder vind je een selectie van onderwerpen en kanalen die je mogelijk interessant vindt omdat je er al iets van hebt bekeken, en video’s van kanalen die je volgt. Een aantal van deze aanbevelingen komt in de rechterbalk te staan naast de video (met de tekst recommended for you).

Het tweede type aanbevelingen zijn video’s van hetzelfde kanaal waar je net een video van hebt zitten bekijken. Als je een filmpje van Martin Sellner opzet, krijg je meer materiaal aangeboden van zijn kanaal, want blijkbaar ben je in zijn werk geïnteresseerd.

Het derde type aanbevelingen betreft de verwante video’s. Dit zijn video’s die vaak samen worden bekeken, denk aan ‘mensen die deze video bekeken, keken ook naar…’. Dit type aanbeveling is inmiddels goed onderzocht om de simpele reden dat data hierover makkelijk toegankelijk zijn. Guillaume Chaslot en de Duitse onderzoekers baseren zich op dit type als ze zeggen dat aanbevelingen steeds extremer worden.

Het vierde type aanbeveling is een zogenoemde A/B-test. Deze worden gebruikt om de aanbevelingen te verbeteren. Groep A krijgt bijvoorbeeld video A voorgeschoteld. Groep B video B. Na verloop van tijd wordt gekeken waarop het meest wordt geklikt. Stel het is video A. Dan krijgt iedereen voortaan die video te zien.

Zijn we daarmee overgeleverd aan een ingewikkeld stuk technologie?

Nee, want YouTube past de manier waarop die aanbevelingen werken continu aan. In een reactie op ons onderzoek laat een woordvoerder ons weten dat de afgelopen jaren veel is veranderd. Een paar jaar geleden bleken gebruikers gefrustreerd te raken dat ze steeds clickbait met misleidende titels en beschrijvingen kregen aanbevolen. Het aanbevelingsalgoritme is toen aangepast om niet alleen naar views te kijken, maar ook naar likes, dislikes en andere data.

Recentelijk, zegt een woordvoerder, kreeg YouTube klachten dat de aanbevelingen te veel op elkaar leken. Het algoritme is daarom ingesteld om meer verschillende onderwerpen te selecteren.

Vorige zomer liet YouTube weten dat ze ‘betrouwbare nieuwsbronnen’ hoger in de aanbevelingen zou zetten dan onbetrouwbare. Dit na hevige kritiek op de vloed van misleidende complotfilmpjes naar aanleiding van de school shooting in Parkland, Florida.

En onlangs maakte YouTube ook bekend dat ‘borderline content die gebruikers schadelijk kunnen misleiden’ in de toekomst niet meer in de aanbevelingen zal opduiken. Dit is echter nog een proef, die voorlopig alleen in de Verenigde Staten wordt uitgevoerd.

Daarnaast traint YouTube software die automatisch video’s moet herkennen die de voorwaarden van het platform overtreden. Tussen juli en september 2018 haalde YouTube bijvoorbeeld naar eigen zeggen 7,8 miljoen video’s offline en werd 81 procent van die video’s door software als potentieel problematisch aangemerkt. Driekwart van die door software aangemerkte video’s had nog geen enkele view gegenereerd. YouTube probeert dus content in een zo vroeg mogelijk stadium te verwijderen.

Deze voorbeelden geven aan dat YouTube de algoritmes niet helemaal vrijlaat, dat het bedrijf wel degelijk keuzes maakt. De vraag is: is het genoeg?

Deze voorbeelden geven aan dat YouTube de algoritmes niet helemaal vrijlaat, dat mensen er wel degelijk keuzes maken in wat wel en niet wordt gepromoot of toegestaan. De vraag is, is dit genoeg, want er blijven zoveel hatelijke video’s en reacties ongemoeid. En je moet het wel heel bont maken wil je als maker van YouTube verwijderd worden.

Daarnaast zegt YouTube dat het niet met de botte bijl op de vrijheid van meningsuiting wil inhakken.

Illustratief hiervoor is de reactie van YouTube op een deel van de verzamelde data die De Correspondent en de Volkskrant voor het onderzoek hebben gebruikt. Tussen deze data, die wij deelden met het Amerikaanse hoofdkantoor van YouTube, zitten reacties (comments) waarin gesproken wordt over ‘ongedierte uit de derde wereld’, en antisemitische video’s als The Jewish Question Explained in 4 Minutes die wil aantonen hoe Joden de westerse beschaving hebben ‘ondermijnd’.

YouTube laat in een reactie per mail weten dat de video’s en reacties bij video’s ‘bij een eerste bestudering’ niet indruisen tegen de richtlijnen van het videoplatform. Daarin staat dat YouTube geen video’s accepteert die aanzetten tot geweld of haat op basis van ras, etniciteit, nationaliteit, religie of geslacht. Echter: wat aanzet tot haat en wat binnen de grenzen van vrijheid van meningsuiting valt, is niet altijd even makkelijk te bepalen, stelt YouTube. ‘De vrijheid van meningsuiting staat aan de basis van YouTube. Om die reden laten we ook content toe van mensen die controversiële of aanstootgevende overtuigingen delen.’

Voor de fijnproevers, hoe werken die algoritmes dan precies?

De filmpjes die je uiteindelijk aanbevolen krijgt, hebben een snoeiharde afvalrace overleefd. Ze zijn door twee filters gekomen. De eerste filter is de zogenoemde Candidate Generation Filter. De deep neural networks van YouTube – een geavanceerde vorm van kunstmatige intelligentie – gebruiken onder meer jouw demografische gegevens en kijkgeschiedenis om te bepalen wat mensen zoals jij bekeken hebben en wat jouw type gebruiker interessant vindt. Daar komt een lijst van enkele honderden video’s uit.

Vervolgens wordt die lijst door een andere Ranking Filter gepompt. Die bepaalt de volgorde, en die is wederom afhankelijk van een aantal persoonlijke eigenschappen, maar ook van de ‘versheid’ van de items.

Video’s die kort voor je bezoek zijn geüpload, worden bijvoorbeeld hoger gescoord. We weten dit omdat in 2016 enkele onderzoekers een paper publiceerden waarin ze het nieuwe aanbevelingssysteem, dat toen werd uitgerold, analyseerden. Dat systeem was zeer complex en maakt gebruik van de eerdergenoemde deep neural networks.

De Amerikaanse marketeer Matt Gielen heeft voor een wat minder technisch publiek de belangrijkste punten op een rij gezet. Er zijn volgens hem bij dit algoritme drie factoren van groot belang die bepalen of je een video krijgt aangeboden.

- De eerste is de zogenoemde watch time. Dit is niet de tijd die je aan een video besteedt, maar de tijd die je op het platform doorbrengt. Stel, je bekijkt voor driekwart een video over ras en IQ van Jared Taylor. Daarna klik je op een video van een uur waarin neonazi Richard Spencer in discussie gaat met de rechtse YouTuber Sargon of Akkad en je kijkt die helemaal uit. Vervolgens kijk je nog een korte TED-Talk over de edele kunst van het uitstellen. De Watch Time van Taylor’s video is dan behoorlijk indrukwekkend: je bent na die video zomaar twee uur op het platform gebleven. Hiermee stijgt de kans dat deze video vaker wordt aanbevolen, zowel bij jou als bij anderen.

- Een tweede factor is zoekgeschiedenis. Als je veel naar ras en IQ hebt gezocht, zul je daar ook meer video’s over aanbevolen krijgen.

- Een derde factor is de vaagste en geheimzinnigste: demografische informatie zoals leeftijd, geslacht, woonplaats en honderden andere variabelen waarover YouTube zwijgt.

Dus, hoe val je in de rabbit hole?

Dat heeft voor een groot deel te maken met het soort platform dat YouTube eigenlijk is: een mediaplatform waarvoor met name niches heel belangrijk zijn. Daar komt bij dat de aanbevelingsalgoritmes je op veel verschillende manieren die niches laat verkennen en je daarin vasthouden.

Gebruik je YouTube alleen om kinderfilmpjes of modeltreinvideo’s te bekijken, dan is de kans niet groot dat je zomaar politiek extreme content te zien zult krijgen. Zoek je daarentegen naar informatie over maatschappelijk gevoelige thema’s dan zul je er makkelijk op stuiten.

Het is dus niet zo dat je automatisch door YouTube naar extreme content wordt geleid, maar als je eenmaal de eerste schreden hebt gezet, al is het uit nieuwsgierigheid, word je er zó verder ingezogen.

Dit artikel is deel van een langlopende serie op De Correspondent over extreme politieke bewegingen. Deze serie wordt financieel gesteund door het Fonds Bijzondere Journalistieke Projecten. De Volkskrant heeft geen bijdrage van het fonds gehad voor haar werk.

Meer lezen?

Dit verhaal heb je gratis gelezen, maar het maken van dit verhaal kost tijd en geld. Steun ons en maak meer verhalen mogelijk voorbij de waan van de dag.

Al vanaf het begin worden we gefinancierd door onze leden en zijn we volledig advertentievrij en onafhankelijk. We maken diepgravende, verbindende en optimistische verhalen die inzicht geven in hoe de wereld werkt. Zodat je niet alleen begrijpt wat er gebeurt, maar ook waarom het gebeurt.

Juist nu in tijden van toenemende onzekerheid en wantrouwen is er grote behoefte aan verhalen die voorbij de waan van de dag gaan. Verhalen die verdieping en verbinding brengen. Verhalen niet gericht op het sensationele, maar op het fundamentele. Dankzij onze leden kunnen wij verhalen blijven maken voor zoveel mogelijk mensen. Word ook lid!

/dc-useruploads-images/54ebe274b1414dd58211f9615b03eb0b.png)