Robots gaan de oorlogen van de toekomst voeren (maar niemand weet hoe)

De technologie is bijna zover dat robots onze oorlogen kunnen uitvechten. Maar welke regels en grenzen daarbij moeten gelden, daarover is niemand het met elkaar eens. De wereld van autonome wapens in negen vragen.

Een leger wil een vijandige stad aanvallen, maar is niet bereid soldaten te sturen om straat voor straat te veroveren. In plaats daarvan stuurt het duizenden kleine drones met een simpele opdracht: schiet iedereen neer met een wapen.

De drones worden gelanceerd vanuit vrachtwagens even buiten de stad en zwermen in groepjes op hun doel af. Een paar uur later is de stad gereed om te worden ingenomen. De huizen staan nog overeind, er zijn geen burgers of eigen soldaten omgekomen en de vijand is verslagen.

Hoe hypothetisch bovenstaande anekdote ook klinkt, de bouwstenen voor de technologie bestaan al. Zulke door algoritmes gestuurde minidrones zijn nu nog ongewapend en weinig effectief, maar naarmate gezichtsherkenning en algoritmische besluitvormingsprocessen zich verder ontwikkelen, komen deze volledig autonome killerdrones steeds dichterbij.

Dat roept vele ethische, technische en strategische dilemma’s op. In de eerste plaats: willen we wel dat robots beslissen over leven en dood? Het wordt hoog tijd dat we ons daar serieus over buigen. Want of we het willen of niet: een wereld waarin robots oorlog voor of tegen ons voeren is nabij.

Begin deze week waarschuwde vredesorganisatie PAX in een nieuw rapport dat zelfs grote techbedrijven als Microsoft en Amazon zich bezighouden met het ontwikkelen van de technologie achter wat PAX ‘killer robots’ noemt. Daarom: de wereld van de autonome wapens in negen vragen.

Om te beginnen: wat zijn autonome wapens?

Autonome wapens kunnen zelfstandig doelen zoeken en aanvallen. Wat of wie ze moeten raken en hoe, hangt af van hun programmering. Dat is niet los te zien van de opkomst van AI (kunstmatige intelligentie), vaak omschreven als ‘de volgende industriële revolutie’.

Waar de eerste industriële revolutie machines bracht die fysiek beter in staat waren om bepaalde militaire taken uit te voeren dan mensen – denk aan tanks, vliegtuigen en machinegeweren – zorgt AI ervoor dat machines ook cognitief militaire taken kunnen overnemen van mensen. Autonome wapens kunnen straks supersnel en heel precies grote hoeveelheden data vergaren, analyseren, zelfstandig omzetten in een aanvalsplan en zelfs overgaan tot een aanval, waardoor je veel minder mankracht nodig hebt dan als mensen dit zouden doen.

En, zijn ze er al?

Ja. Meer dan dertig landen beschikken al over defensieve autonome wapensystemen, voor situaties waarin mensen een te lage reactiesnelheid hebben om adequaat te reageren. Bijvoorbeeld wanneer een vijand vijftig raketten tegelijk op je afvuurt.

Het Nederlandse leger beschikt bijvoorbeeld over een Patriot-luchtverdedigingssysteem. Dit kan volledig automatisch ballistische raketten uit de lucht schieten, zonder dat een mens iets hoeft te doen, aldus het ministerie van Defensie.* Een mens kan het systeem wel elk moment uitzetten.

De Amerikanen gaan een stap verder en zijn bezig een schiettoren te ontwikkelen die zelfstandig (menselijke) doelwitten opspoort en inschat of ze vijandig zijn om zonder toezicht van een mens tot een aanval over te kunnen gaan.* Zuid-Korea heeft een vergelijkbare, zij het minder geavanceerde wachttoren geïnstalleerd aan de grens met Noord-Korea. Zestien landen bezitten gewapende drones die nu nog op afstand worden bestuurd door mensen, maar steeds meer taken autonoom kunnen uitvoeren.

Israël heeft een aanvalswapen ontworpen dat de grens naar volledige autonomie al is gepasseerd. De zogeheten Harpy-drone kan zelfstandig een groot gebied afzoeken naar radarsystemen om ze vervolgens uit te schakelen, zonder tussenkomst van een mens en zonder dat een mens van tevoren weet welk doel er precies wordt aangevallen. De Harpy is verkocht aan Turkije, India en Zuid-Korea. China heeft een eigen variant van deze drone gemaakt.

In een ideale wereld zou de Harpy moeten werken zoals onderstaand pr-filmpje laat zien: doelgericht, nauwkeurig en uiterst effectief.

Waarom willen legers eigenlijk volledig autonome aanvalswapens?

Als je een conflict wilt winnen of jezelf wilt beschermen tegen je buurman, hebben autonome wapens zo hun voordelen.

In de eerste plaats zijn er veel minder mensen nodig om autonome wapens te bedienen. ‘Piloten’ die de huidige generatie drones van een afstand besturen, moeten worden opgeleid en betaald, terwijl ontelbare relatief goedkope autonome drones in theorie een aanval kunnen uitvoeren op een veelvoud aan doelen zonder dat er mensen voor nodig zijn.

Verder zijn volledig autonome wapens niet afhankelijk van kwetsbare communicatielijnen die door tegenstanders verstoord kunnen worden, wat bij door mensen bestuurde drones ertoe zou leiden dat ze onbestuurbaar worden. Zonder die communicatie kunnen wapens slechts simpele, van tevoren bedachte taken uitvoeren.

Autonome wapens kunnen zelfstandig een doelwit kiezen, een aanval eventueel afblazen, of een nieuw, effectiever aanvalsplan bedenken als de situatie daar om vraagt. Dat biedt strategische voordelen, maar kan oorlog ook humaner maken, stellen voorstanders. De wapens doen immers precies wat je ze opdraagt, en worden niet moe of angstig waardoor ze afwijkend gedrag vertonen. Al schiet je honderd robots neer, dan nog zal de volgende geen wraak willen nemen.

Prachtig, maar niemand gelooft dat er slechts voordelen zijn. Dus: wat kan verkeerd gaan?

Wie af en toe een sciencefictionfilm bekijkt, weet dat zelfdenkende robots ook voor problemen kunnen zorgen. In Terminator wordt een militair systeem genaamd Skynet zich bewust van zichzelf. Zijn menselijke operators proberen hem vervolgens uit te zetten, maar dat is tegen het zere been van Skynet, waarop het systeem een nucleair armageddon in gang zet om de mensheid uit te roeien. Menselijke strijders wacht vervolgens een bijna onmogelijke taak om het systeem alsnog uit te zetten.

Te ongeloofwaardig, dit verhaal? Ga even mee terug naar de nacht van 26 september 1983. De Koude Oorlog is op zijn hoogtepunt, de VS en de Sovjet-Unie houden elkaar permanent met kernwapens onder schot. Drie weken eerder heeft het Sovjetleger nog een passagiersvliegtuig neergeschoten dat op weg was van Alaska naar Seoul, waarbij 269 passagiers omkwamen, onder wie een Amerikaans Congreslid. Uit vrees voor vergelding houden de Sovjets het luchtruim goed in de gaten met een op satellietbeelden gebaseerd waarschuwingssysteem, genaamd Oko.

Petrov heeft slechts enkele minuten voordat de raketten inslaan. Maar hij besluit zijn bazen niet te waarschuwen

Kort na middernacht slaat Oko alarm: de VS heeft een kernraket afgeschoten op de Sovjet-Unie. Luitenant-kolonel Stanislav Petrov heeft die nacht dienst en heeft als taak deze boodschap door te geven aan zijn bazen. Maar hij twijfelt. Oko is nieuw, en het systeem kan ook fout zitten, redeneert hij. Een tegenreactie zou een kernoorlog veroorzaken en het einde van de mensheid kunnen inluiden.

Dan volgt een tweede lancering van een raket, volgens Oko, en een derde, totdat er maar liefst vijf kernraketten vanuit de VS naar de Sovjet-Unie op weg zouden zijn. Oko verandert de waarschuwing van ‘lancering’ naar ‘raketaanval’. Petrov heeft slechts een paar minuten de tijd om te beslissen wat hij zal doen voordat de raketten inslaan. Maar hij besluit zijn gevoel te volgen en de boodschap niet door te geven aan zijn bazen.

In plaats daarvan belt hij een ander radarstation en vraagt of zij iets zien. Dat is niet zo. De kans op een aanval schat Petrov op dat moment op 50 procent, zal hij later zeggen. Dan pakt hij de telefoon en belt hij zijn bazen met de boodschap dat het systeem niet functioneert.

Hij heeft gelijk: er kwam geen aanval. Zonlicht dat weerkaatste op wolkentoppen had een vals alarm veroorzaakt. Het was enkel te danken aan een mens dat een door machines ingeluid potentieel armageddon was voorkomen.

Zo’n voorbeeld is toch genoeg reden om in paniek te raken?

Nou, het laat in elk geval zien hoe belangrijk het is dat mensen de controle voeren over machines. Robots doen enkel waarvoor ze zijn geprogrammeerd en hebben geen zicht op de context en de rol van de mensen. Empathie kennen ze niet, de gevolgen van hun handelen is hen vreemd.

Maar hoe de meest geavanceerde autonome wapensystemen van de toekomst precies zullen werken weet niemand. Machine learning is in sommige gevallen zo complex dat het zelfs voor programmeurs vrijwel onmogelijk is te achterhalen hoe beslissingen precies tot stand komen. Het is moeilijk te voorspellen waar dit in chaotische gevechtssituaties toe leidt.

Volledig autonome wapens kunnen dus beslissingen nemen die onvoorziene gevolgen hebben. Zo is het niet ondenkbaar dat wapensystemen elkaar per ongeluk in werking stellen en daarmee een allesvernietigende oorlog in gang zetten. Of zich tegen mensen keren die niets hebben misdaan.

Autonome legers zijn ook goed in staat genocides uit te voeren, waarschuwt bijvoorbeeld Ariel Conn, directeur communicatie bij het Future of Life Institute, op de Amerikaanse website Vox.* Je selecteert simpelweg de eigenschap waarmee een bepaalde groep zich onderscheidt, zoals huidskleur, kleding of lengte, en draagt het wapen vervolgens op iedereen die daaraan voldoet te doden. Mocht zulke technologie in handen vallen van kwaadwillenden, dan zijn de gevolgen niet te overzien.

Tegenstanders vrezen ook voor een veel lagere drempel om mensen te doden als we dit overlaten aan machines. Een vijand wordt zo veel meer een nummer op een scherm. En als mensen machines te veel vertrouwen, en geen vragen meer stellen over de technologie erachter, verliest oorlog een belangrijke menselijke component: compassie.

De Campaign to Stop Killer Robots pleit daarom voor een verbod op volledig autonome wapens. Deze in 2013 opgerichte non-gouvernementele organisatie stelt dat mensen altijd de controle over machines moeten behouden. Ze krijgt steun van 28 landen, ruim honderd ngo’s, het Europese Parlement, secretaris-generaal van de VN António Guterres, 21 Nobelprijs-winnaars en meer dan 25.000 AI-experts.

Welke landen zitten vooral achter de ontwikkeling van deze wapens?

De totstandkoming van dodelijke autonome wapensystemen is vooral het gevolg van angst voor elkaar. Als de Amerikanen iets kunnen, willen de Chinezen en Russen niet achterblijven. Waarna de Amerikanen hun voorsprong verder proberen uit te bouwen – en dit proces zich herhaalt.

Die wapenwedloop wordt vooral aangedreven door de uitgaven van het Amerikaanse ministerie van Defensie. In 2019 besteedt de VS ruim 625 miljard euro aan defensie,* meer dan de gezamenlijke defensieuitgaven van de zeven landen die onder de VS staan in de top tien van landen met hoge defensiebudgetten.

Het is lastig te achterhalen hoeveel van dat geld naar autonome wapens gaat. Er bestaan nu al veel wapens die gedeeltelijk autonoom functioneren. Waar leg je dan de grens? Dit boekjaar besteden de Amerikanen bijvoorbeeld 8,4 miljard euro aan de ontwikkeling van ‘onbemande systemen’, zoals drones, zelfrijdende voertuigen en onbemande onderzeeërs, schrijft de Amerikaanse technologiewebsite The Verge.* Een update van hun software kan deze in de toekomst mogelijk volledig autonoom laten functioneren.

Een aantal robotica-projecten is al gestopt omdat de Amerikaanse legertop er geen vertrouwen meer in had

Vaak worden investeringen ook uitgesmeerd over een langere periode. Afgelopen september beloofde het Pentagon het militaire onderzoekslaboratorium DARPA nog 2 miljard dollar om de komende vijf jaar meer kunstmatige intelligentie in het Amerikaanse wapenarsenaal te integreren. Dat is gelijk de grootste investering in AI-systemen voor wapentuig ooit. *

Hoe belangrijk de Amerikanen autonome wapens vinden voor de toekomst, blijkt ook uit de in 2014 gelanceerde Third Offset Strategy. Daarin vertellen de Amerikanen hoe ze hun rivalen op technologisch gebied voor denken te blijven. De focus voor de komende decennia ligt op robotica, autonomie en mens-machine-teaming (het samenwerken van mens en machine).

Toch staat niet vast dat de Amerikanen echt zwaar willen leunen op volledig autonome wapens. Verschillende ambitieuze roboticaprojecten zijn al gestopt omdat in de legertop onvoldoende vertrouwen heerst in het functioneren van de technologie erachter, aldus de Amerikaanse ex-marinier Paul Scharre in ‘Army of None: Autonomous Weapons and the Future of War’.

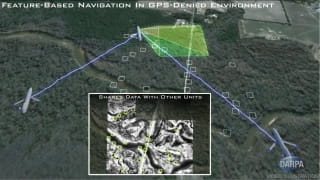

In plaats daarvan lijkt de VS vooral te willen inzetten op betere samenwerking tussen mensen en vergaand autonoom wapentuig, om het beste van beide te combineren. Onderstaand filmpje is daar een voorbeeld van. Nieuwe algoritmes en software stellen onbemande, door mensen aangestuurde vliegtuigen in staat onderling samen te werken en taken autonoom uit te voeren zodra communicatie met de thuisbasis niet meer mogelijk is.

Overigens blijven de Amerikanen nog steeds veel meer investeren in conventionele wapensystemen, waaronder vernieuwde hypersonische raketten.

En de andere landen? Hoe pakken die het aan?

De Chinese autoriteiten noemen de inzet van dodelijke autonome wapens in de toekomst ‘onvermijdelijk’. Tegelijkertijd zien ze ontwikkeling van kunstmatige intelligentie als een manier om de achterstand op militair gebied met de VS in te halen. *

Dat zorgt voor miljardeninvesteringen in AI, een groeiende productie van vergaand autonome wapens en stijgende wapenexporten. China exporteert nu al veel geavanceerde gewapende drones met grote autonomie, naar landen als de Verenigde Arabische Emiraten, Saoedi-Arabië en Nigeria. De afgelopen jaren zijn zulke Chinese drones ingezet in gevechtssituaties in Libië, Jemen, Egypte en Nigeria.*

Dan Rusland. De Russische president Vladimir Poetin zei in 2017: wie AI controleert, controleert de wereld.* Met een veel kleiner budget dan de VS en China is ook Rusland AI-technologie in zijn wapens aan het integreren. Zo ontwikkelde het een onbemande autonome tank, die tijdens de oorlog in Syrië al is ingezet. Veel succes had die tank overigens niet: het contact met de basis viel twee keer voor anderhalf uur weg, doelwitten konden slechter dan gehoopt worden geïdentificeerd en het voertuig kon enkel schieten vanuit stilstand. *

In Nederland ten slotte, bevindt alles zich nog in de fase van ‘onderzoek’. Het leger bereidt zich voor op de komst van autonome systemen op het slagveld. Om erachter te komen hoe dit de krijgsmacht kan helpen, heeft Defensie in 2018 de tien man tellende ‘robots and autonomous systems’- eenheid opgericht (RAS). Onderzoeksinstituten, technische universiteiten en het bedrijfsleven denken ook mee.

Kan niet iemand een wet bedenken om alles een beetje onder controle te houden?

Was het maar zo gemakkelijk. Sinds 2017 komen deskundigen uit verschillende landen twee keer per jaar bijeen in Genève op uitnodiging van de United Nations Convention on Certain Conventional Weapons (CCW). Hun opdracht: zoeken naar overeenstemming over de manier waarop landen moeten omgaan met autonome wapens, in de hoop dat er ooit een VN-verdrag komt met scherpe regels hiervoor. Maar consensus bereiken gaat traag, en een eerste ‘draft’ van zo’n verdrag is nog lang niet in zicht. Er is zelfs geen overeenstemming over wat autonome wapens precies zijn.

Deze woensdag komt de expertgroep weer bij elkaar in Genève. Maar nu al staat vast dat er geen verbod op autonome wapens zal komen. De VS, Rusland, het VK, Israël, Zuid-Korea en Australië zijn in elk geval tegen. Zo’n ban nog voordat de humanitaire voordelen van zulke wapensystemen zijn onderzocht, noemen ze voorbarig.

Wat ook meespeelt is de vrees dat hun rivalen zich niet zullen houden aan een eventueel verbod. Want hoe handhaaf je zoiets?

Intussen stellen verschillende landen hun eigen regels op. Zo bepaalt Amerikaanse wetgeving dat autonome en semi-autonome wapensystemen zo moeten zijn gemaakt dat operators altijd een ‘gepast menselijk oordeel’ kunnen uitoefenen over de inzet van geweld. Maar wat ‘gepast’ precies inhoudt, is niet duidelijk.

China zegt naar overeenstemming met andere landen te streven over het gebruik van autonome wapens, maar geeft geen openheid over wat het zelf op dit gebied doet. Rusland pleitte* in april voor het eerst voor betere internationale regulering van nieuwe technologieën in de militaire sfeer, maar houdt net als China veel van de eigen plannen geheim.

Nederland houdt zich enigszins op de vlakte. In april verklaarde de Nederlandse afgevaardigde in de expertgroep dat zolang autonome wapens onder ‘betekenisvolle menselijke controle staan’, er geen reden is om aan te nemen dat deze wapens per definitie vallen in een van de categorieën wapens die volgens het internationale recht verboden zijn.

Wat vind jij?

Hoe onwerkelijk killerrobots ook klinken, ze zijn onderdeel van de grotere ontwikkeling waardoor AI steeds meer onderdeel van onze levens wordt. De technologie is alom aanwezig en makkelijk te reproduceren, en lijkt daardoor moeilijk te stoppen. Als dit een beslissend voordeel op het strijdveld oplevert, zal een totaalverbod er nooit komen.

Dat betekent niet dat we geen invloed hebben op de manier waarop autonome wapens worden ingezet en hoeveel autonomie ze krijgen. Het betekent evenmin dat als ze er komen, ze van de wereld een onmenselijke plek zullen maken. Uiteindelijk zijn wij het die de machines maken en controleren, en niet andersom.

De discussie hoe we dat doen, is te belangrijk om over te laten aan legerleiders, technische ingenieurs of wapenfabrikanten. Dit zijn vragen die ons allemaal aangaan, en ook onze kinderen en hún kinderen. Als robots de oorlogen van de toekomst gaan uitvechten, is dit het moment waarop we invloed moeten uitoefenen op de manier waarop ze dit doen. De code voor die systemen – het DNA van de killerrobots – wordt nu geschreven.