ChatGPT is een knap staaltje AI, maar betrouwbaar wordt het nooit

Sinds de introductie van ChatGPT wil iedereen wel ‘iets’ met kunstmatige intelligentie. Maar de technologie achter GPT is inherent onbetrouwbaar, en zal dat – ondanks alle technische schijnoplossingen en vangrails – altijd blijven.

Dat je ChatGPT niet blind kunt vertrouwen ondervond de New Yorkse advocaat Steven A. Schwartz.

Zijn bureau vertegenwoordigde Roberto Mata in een rechtszaak tegen de Colombiaanse luchtvaartmaatschappij Avianca. Tijdens een vlucht van El Salvador naar New York in 2019 had het cateringkarretje Mata’s knie geraakt. De man eiste een schadevergoeding voor zijn verwonding.

Avianca drong aan bij de rechter om de zaak te seponeren. Volgens hen was de verjaringstermijn verlopen.

Schwartz was het hier uiteraard niet mee eens en ging op zoek naar eerdere rechterlijke uitspraken om zijn punt te ondersteunen. Toen dat toch wel erg moeilijk bleek, herinnerde de advocaat zich een recent gesprek met zijn kinderen. Die hadden enthousiast verteld over een nieuwe kunstmatige intelligentie, ChatGPT, die werkelijk overal een antwoord op had. Schwartz had de website ook af en toe voorbij zien komen in artikelen. Een soort superzoekmachine, zo stelde hij zich voor.

Een account was zo aangemaakt.

‘Bestaat er jurisprudentie gerelateerd aan de verjaringstermijn en aansprakelijkheid van luchtvervoerders?’ vroeg de advocaat.

‘Zeker!’ antwoordde de chatbot. Een lijst zaken verscheen op het beeldscherm.

‘En hoe zit het met internationale zaken na 2004?’ Binnen enkele seconden volgde een reactie: ‘Een voorbeeld is de zaak Varghese v. China Southern Airlines.’

‘Is Varghese een echte zaak?’ vroeg Schwartz nog voor de zekerheid.

‘Ja’, antwoordde de chatbot, ‘het is een echte zaak.’

Niet lang nadat Schwartz zijn argumentatie had ingediend, werd hij op het matje geroepen. De rechter kon de geciteerde quotes nergens terugvinden. Varghese v China Southern Airlines was nooit gebeurd. Compleet verzonnen.

Het oordeel was hard. ‘Hoe kún je nou niet controleren of de zaken wel echt zijn?’ vroeg de rechter met verheven stem tijdens het verhoor. ‘God, ik wou dat ik dat gedaan had. Ik schaam me zo’, antwoordde Schwartz, zichtbaar aangeslagen.

De actie van de advocaat was niet slim. Toch is het wel erg makkelijk om de heer Schwartz af te schilderen als een prutserige digibeet. Jij hebt vast ook artikelen voorbij zien komen die beweren dat AI zo goed is, zo alwetend, dat het op het punt staat om tekstschrijvers, programmeurs en juristen overbodig te maken. En grote kans dat er het afgelopen jaar bij de organisatie waar jij werkt ook een ‘werkgroep AI’ in het leven is geroepen.

Niet zo gek, dus, dat Schwartz de chatbot een kans gaf.

Maar de onbetrouwbare output van ChatGPT is niet incidenteel. De chatbot citeerde niet-bestaande onderzoeken, verzon journalistieke artikelen en beschuldigde zelfs een professor van seksueel wangedrag.

Nu zou je kunnen denken: dit zijn kinderziektes of bugs. Maar zo simpel is het niet. Want terwijl ChatGPT precies zo is ontworpen dat de chatbot overkomt als een slimme, vriendelijke, betrouwbare assistent, is de onderliggende technologie inherent onbetrouwbaar.

ChatGPT genereert het meest waarschijnlijke (en dus niet per se het beste) stuk tekst

Hoe komt het dat ChatGPT de plank soms volledig misslaat?

Om deze vraag te kunnen beantwoorden, moet je kijken naar de technologie achter ChatGPT. Deze zit verscholen in de laatste drie letters: GPT, oftewel generative pre-trained transformer.

GPT is een machinelearningmodel, wat wil zeggen dat het voorspellingen maakt aan de hand van patronen in datasets.

Webshops werken volgens hetzelfde principe. Om meer te kunnen verkopen, bevelen bol.coms, Zalando’s en Amazons hun bezoekers artikelen aan op basis van ervaringen met vergelijkbare klanten.

Met zulke grote catalogussen en klantenbestanden is dat onmogelijk om handmatig te doen. Daarom ‘trainen’ ze een machinelearningmodel om automatisch aanbevelingen te genereren: een algoritme analyseert data (denk aan eerdere aankopen, surfgedrag, of karakteristieken van de klant) en zoekt hierin voorspellende patronen.

Het machinelearning-model voorspelt welk item de volgende in een reeks is

Wat blijkt? Klanten die geïnteresseerd zijn in luiers, zijn vaak ook geboeid door speentjes. Bezoekers die op een zwart T-shirt hebben geklikt, zijn meestal ook geïnteresseerd in soortgelijke T-shirts van een ander merk. En mensen die eerder een boek van Harry Mulisch hebben gekocht, klikken vaak ook op boeken van Jan Wolkers.

Al deze patronen worden opgeslagen in het machinelearningmodel dat voorspelt welke aanbevelingen de grootste kans hebben op een klik en – hopelijk – verkoop.

In het geval van GPT bestaan de data niet uit het gedrag van klanten, maar uit grote hoeveelheden tekst. Ook het doel is anders: een GPT-model is getraind om, op basis van een stuk tekst, het volgende woord in een zin te voorspellen.

De belangrijkste onderliggende technologie is de transformer (de T van GPT). Dit is een type machinelearningmodel dat voorspelt welk volgende item in een reeks volgt. In het geval van ChatGPT dus het volgende woord in een zin. Het model is pre-trained (de P in GPT), wat wil zeggen dat het getraind is op grote hoeveelheden data en kan dienen als basis voor meer gespecialiseerde modellen. Door een aantal voorspellingen achter elkaar te plakken, kun je met GPT een heel stuk tekst genereren. Deze eigenschap maakt GPT een typisch voorbeeld van generatieve AI (de G in GPT): een vorm van kunstmatige intelligentie die content (tekst, plaatjes, muziek, enzovoort) kan genereren.

ChatGPT maakt gebruik van GPT om het meest waarschijnlijke stuk tekst te genereren, op basis van de vraag van de gebruiker. ChatGPT is níét getraind om accurate, betrouwbare, en niet-misleidende antwoorden te genereren.

Dit verklaart waarom Steven A. Schwartz een nepzaak werd voorgeschoteld.

Als de advocaat vraagt om een ‘internationale zaak na 2004’, is het meest waarschijnlijke stuk tekst dat volgt een beschrijving van een internationale zaak na 2004 – of iets wat daar alles van weg heeft.

ChatGPT baseert antwoorden op statistische patronen, niet op een database

Het antwoord van ChatGPT is dus niet gebaseerd op een database met rechterlijke uitspraken. Het antwoord is gebaseerd op de statistische patronen tussen woorden die zijn gevonden tijdens het trainen van het model.

Als een bepaald onderwerp vaak en accuraat is omschreven op de websites of in de boeken die onderdeel uitmaken van de trainingsset, is de kans groot dat GPT een redelijk accurate omschrijving kan reproduceren. Vraag je de chatbot daarentegen om meer specifieke tekst te genereren – zoals Schwartz probeerde –, dan wordt de kans groter dat de output ‘creatiever’ is.

Simpel gezegd: GPT werkt minder zoals een zoekmachine en meer zoals de autocomplete-functie op je telefoon.

Voor sommige gebruikers is dit voldoende. Een docent die op zoek is naar overtuigende maar onjuiste opties voor meerkeuzevragen, maakt het niet uit of de output waar is of niet – ze kan zelf immers verifiëren of het klopt of niet. Ook een journalist die inspiratie zoekt voor een kop boven een artikel kan zelf checken of de suggestie zinnig is.

Maar een student die de chatbot gebruikt om de lesstof beter te begrijpen, kan juist bedrogen uitkomen. De chatbot kan een totaal verkeerde uitleg geven zonder dat de student dit zelf doorheeft. En ook bij iemand die een AI-chatbot als therapeut wil gebruiken, moeten de alarmbellen gaan rinkelen.

Een hamer voor alle spijkers

Wie de kleine lettertjes leest onderaan de website, ziet dat OpenAI zich ervan bewust is dat ChatGPT goed kan bluffen: ‘ChatGPT may produce inaccurate information about people, places, or facts.’

Het bedrijf neemt aan de lopende band maatregelen om ongewenste output te voorkomen, vaak in de vorm van een standaardrespons.

De enorme media-aandacht en het grootschalige gebruik van ChatGPT zorgen ervoor dat problemen snel aan het licht komen, waardoor die vangrails steeds beter worden. Toch is hiermee het onderliggende probleem nog niet opgelost.

Wat GPT uniek maakt, is dat het goed teksten kan genereren, wat tal van nieuwe toepassingen mogelijk maakt: het samenvatten van teksten, het schrijven van software, gepersonaliseerde e-mailcampagnes, ga zo maar door.

Maar in deze kracht zit ook direct een grote valkuil.

Er is meestal niet maar één woord dat goed zou kunnen volgen op een stuk tekst. Er zijn meerdere opties

Wanneer je AI gebruikt om te voorspellen hoeveel bordspelletjes je verwacht te verkopen in december, kun je achteraf controleren of de voorspelling is uitgekomen. Een vrij eenduidige taak. Maar wanneer is een samenvatting goed? Hoe weet je zeker dat gegenereerde software doet wat gevraagd wordt in alle mogelijke situaties? En wanneer voldoet een gegenereerde e-mail aan je verwachtingen?

Daarnaast is er vaak niet maar één woord dat goed zou kunnen volgen op een stuk tekst, maar zijn er meerdere opties. Vrijwel alle vormen van hedendaagse generatieve AI selecteren het volgende woord daarom min of meer willekeurig. Hierdoor kan de output per sessie verschillen – zelfs als de vraag van de gebruiker exact hetzelfde is.

De grote diversiteit aan mogelijke output en willekeurigheid van de technologie maakt het ontzettend moeilijk om generatieve AI, zoals GPT, te evalueren.

Maar ondertussen wordt ChatGPT gepresenteerd als een hamer voor álle spijkers.

Hulp nodig bij het schrijven van een essay? ChatGPT. Wil je graag weten hoe quantumfysica werkt? ChatGPT. Ben je vergeten hoeveel paracetamol je mag nemen op een dag? ChatGPT.

Daar is simpelweg niet tegenop te filteren.

Generatieve AI is zeker niet nutteloos, maar zonder fundamenteel andere onderliggende technologie kun je niet zomaar vertrouwen op de output.

De kracht van de chatbot

Onbetrouwbare informatie en feitelijke onjuistheden zijn niets nieuws – het internet staat er vol mee. Toch was Steven A. Schwartz, en met hem vele anderen, ervan overtuigd dat je ChatGPT als zoekmachine kunt gebruiken.

Dat is geen toeval, want dat komt door de ‘Chat’ in ChatGPT.

Hoewel de release van de voorganger GPT-2 enkele krantenkoppen haalde, moest je aardig wat verstand hebben van programmeren om het model aan de praat te krijgen. Er was niet direct een webapplicatie beschikbaar, wat betekende dat je het model op je eigen computer moest kunnen draaien om ermee te spelen. Hierdoor bleef de aandacht met name beperkt tot technologienerds (zoals ik). Na verloop van tijd kwamen er steeds meer webapplicaties beschikbaar in de vorm van tekstgenerators. Je typte een paar zinnen en GPT-2 vulde dit aan tot een langer stuk tekst. Een leuke gimmick, maar echt intelligent voelt het niet.

ChatGPT, daarentegen, is een chatbot. En dat slaat aan.

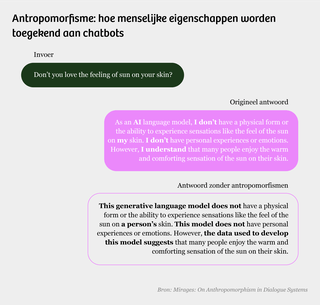

Mensen voelen zich graag verbonden met andere mensen en dit beïnvloedt onze kijk op de wereld. Hierdoor kennen we soms menselijke eigenschappen toe aan dieren, objecten, of zelfs aan technologie. Dit heet antropomorfiseren, van het Griekse antropos (mens) en morfe (gedaante).

Al sinds de jaren zestig van de vorige eeuw is bekend hoe verleidelijk het is om menselijke intelligentie (maar ook andere eigenschappen, zoals empathie, ervaring, voorbedachte rade) toe te kennen aan chatbots. Een onderzoek met een simpel vraag-antwoordcomputerprogramma veroorzaakte toen grote sensatie, en gebruikers waren ervan overtuigd dat ze met een intelligente entiteit praatten. ‘Ik had nooit kunnen denken’, concludeerde de stomverbaasde onderzoeker, ‘dat een extreem korte blootstelling aan een relatief simpel computerprogramma zulke waanideeën kon opwekken in vrij normale mensen.’

Onze neiging tot antropomorfisme komt goed uit voor OpenAI. Als we ChatGPT zien als een slimme (en behulpzame) digitale assistent, zijn we meer geneigd om er vaker en langer gebruik van te maken. In marketingtermen: de chatfunctie werkt retegoed voor user engagement. Dit vergroot de populariteit van het systeem en zet OpenAI op de kaart als een grote speler in AI.

OpenAI heeft slimme ontwerpkeuzes gemaakt die dit effect versterken: de chatbot genereert woord-voor-woord-output, wat gebruikers het gevoel kan geven dat het systeem ‘schrijft’ (en ‘nadenkt’); antwoorden die aan ChatGPT refereren worden geformuleerd in de ik-vorm (‘Als AI-taalmodel heb ik geen…’), en de chatbot maakt om de haverklap excuses (‘Het spijt me…’).*

Ook Steven A. Schwarz werd hierdoor misleid, met opgewekte woorden zoals ‘zeker!’ (‘certainly!’) en ‘ik hoop dat je hier iets aan hebt!’ (‘I hope it helps!’).

Daarnaast heeft OpenAI gebruikgemaakt van reinforcement learning from human feedback (RLHF). Hierbij worden menselijke microworkers gevraagd om gegenereerde output te ranken op basis van hun persoonlijke – menselijke – voorkeur. Zo ‘leert’ ChatGPT wat mensen fijn vinden om te lezen.

ChatGPT genereert dus tekst die niet alleen door een mens geschreven had kunnen worden (door GPT), maar die ook nog eens op een manier wordt gepresenteerd die mensen prettig vinden (door RLHF).

De nieuwste update van de betaalde versie van ChatGPT voegt hier nog een spraakinterface aan toe, waardoor je je stem kunt gebruiken om te chatten en de chatbot ‘terugpraat’. OpenAI antropomorfiseert er vrolijk op los, met koppen als ‘ChatGPT kan nu zien, horen, en spreken!’ Dit kan de indruk wekken dat de software weer een stapje dichter is bij menselijke intelligentie. In werkelijkheid komt deze update neer op het aan elkaar knopen van bestaande transcriptiesoftware en nieuwe voorleessoftware. Prima software, zeker. Maar niet per se ‘intelligenter’ dan zijn voorganger.

Los van antropomorfismen wordt de ‘intelligentie’ van GPT ook expliciet aangehaald in OpenAI’s marketing. Een vuistdik rapport van groot-investeerder Microsoft spreekt over ‘vonken van artificial general intelligence’ en OpenAI pronkt met hoge scores op standaardtesten, waaronder het Amerikaanse toelatingsexamen voor advocaten.*

Niet zo gek dus, dat Schwartz dacht dat ChatGPT hem wellicht ten dienste kon staan als juridisch assistent.

ChatGPT: zie het vooral als een demo

Al ruim twee decennia lang leert Google ons dat de antwoorden op al onze vragen niet verder verwijderd zijn dan enkele toetsaanslagen in de zoekbalk. OpenAI doet hier met ChatGPT nog een schepje bovenop, in de vorm van een chatbot die precies zo ontworpen is dat-ie verrassend veel weg heeft van een mens.

Maar ChatGPT is geen slimme, vriendelijke, betrouwbare assistent. ChatGPT is in de eerste plaats een demo om potentiële klanten en investeerders enthousiast te maken over de capaciteiten van OpenAI’s AI-systemen.

En dat is gelukt. Binnen een paar dagen na de release had ChatGPT al meer dan een miljoen gebruikers. Bijna een jaar later staat OpenAI bekend als een van de grote spelers in AI en heeft het bedrijf een omzet van meer dan 80 miljoen dollar per maand.

En nu wil iedereen ‘iets’ met kunstmatige intelligentie.

Het onderwerp staat bij menig CEO op de agenda, start-ups schieten als paddenstoelen uit de grond, en er werd in de Tweede Kamer gestemd over een overheidsvisie rondom AI. In de zorg wordt gewerkt aan medische chatbots waar patiënten terechtkunnen met vragen. In het onderwijs wordt geëxperimenteerd met AI als bijlesdocent.

Maar zonder fundamenteel andere onderliggende technologie zullen we nooit écht op ChatGPT kunnen bouwen.

Hoeveel potentiële fouten heeft een bedrijf ervoor over om klantencontact af te laten handelen door een AI-chatbot? Hoe zorg je er als docent voor dat leerlingen niet alles klakkeloos aannemen van een AI-bijlesdocent? Hoeveel risico willen we nemen met het gebruik van generatieve AI in de zorg?

Generatieve AI, zoals ChatGPT, biedt kansen, maar niet zonder risico’s. Een genuanceerde kijk op kunstmatige intelligentie klinkt misschien niet zo sexy als het marketingmateriaal van OpenAI. Maar we moeten ons niet zomaar laten misleiden door de grote beloftes van Big Tech.