Normale catastrofes

Nucleaire catastrofes zijn niet uitzonderlijk, ze zijn normaal.

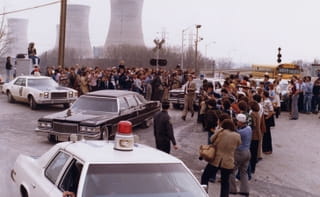

Het was een vroege woensdagochtend in 1979. Een paar uur eerder had de onderhoudsploeg een aantal filters schoongemaakt in de leidingen van een niet eens zo belangrijke watertank. Het was een routineklus. Dit soort schoonmaakwerkjes werden dagelijks uitgevoerd in een van de duizenden leidingen van de Three Mile Island. Het werkje ging echter niet naar behoren: het werd iets te ruw gedaan waardoor er een lek ontstond en te veel druk kwam op het koelingssysteem van de reactor. Geen probleem. Een operateur in het commandocentrum zette een ventiel open om de druk te verminderen. Het ventiel ging daarna weer dicht. Niets aan de hand.

Niet dus. Het ventiel zat vast en de operateur wist van niets. De gevolgen waren dramatisch. Doordat het ventiel openbleef, stroomde koelingsvloeistof weg. De reactorkern raakte oververhit. In de spannende dagen die volgden ging alles mis wat er mis kon gaan. Een grotere catastrofe werd ternauwernood afgewend, maar er werden wel licht radioactieve gassen vrijgelaten en vervuild water in de rivier geloodst. De schoonmaak was pas in 1993 klaar en kostte uiteindelijk een miljard dollar.

Theoretische onmogelijkheid

Het was niet de eerste nucleaire catastrofe en ook niet de laatste. En het was niet de eerste en de laatste keer dat ingenieurs en beleidsmakers verrast waren door een catastrofe die een theoretische onmogelijkheid leek. Er zijn geen andere sectoren te bedenken waar zoveel aandacht is voor veiligheid, waar zoveel voorspellingsmodellen worden gebruikt, scenario’s worden doorgerekend en back up-mechanismen zijn ontworpen.

De kans op een nucleair ongeluk is klein. Heel klein. De kans verschilt per type centrale. Nieuwe centrales zijn veiliger dan oude. In de VS en West-Europa zijn de veiligheidseisen over het algemeen hoger dan in China en in ontwikkelingslanden. Een ernstige beschadiging van een reactorkern, zoals in Tsjernobyl en Fukushima, vindt volgens de heersende voorspellingsmodellen gemiddeld 1 keer in de 10.000-15.000 reactorjaren plaats. Een reactorjaar is een jaar waarin een reactor actief is. De kans dat zo’n ongeluk leidt tot de uitstoot van radioactief materiaal is 0,1 keer in de hele menselijke geschiedenis.

Dat is theorie. In werkelijkheid is het twee keer in 25 jaar gebeurd dat een reactorkern het begaf

Dat is theorie. In werkelijkheid is het twee keer in 25 jaar gebeurd dat een reactorkern het begaf. En dan tellen we Fukushima maar één keer mee, terwijl daar drie reactorkernen smolten (en land, lucht en water ernstig verontreinigden). En Three Mile Island ook niet, omdat het daar om relatief weinig uitgestootmateriaal ging.

Energiedeskundige Benjamin Sovacool becijferde na Fukushima dat tussen 1957 en 2011 102 ongelukken hebben plaatsgevonden. Dat zijn de ongelukken die tot meer dan 50.000 dollar en/of doden hebben geleid en die bekend zijn gemaakt. In werkelijkheid kunnen er nog meer ongelukken hebben plaatsgevonden die nooit naar buiten zijn gebracht. Over China zijn bijvoorbeeld geen data beschikbaar.

Mijn serie over moderne waarzeggers gaat over wat voor rol voorspellingen hebben in onze samenleving en hoe goed of slecht die voorspellingen zijn. Daarbij hoort een analyse over waarom dit soort catastrofes zo moeilijk voorzien kunnen worden. We moeten niet alleen kijken naar de statistiek en techniek van het voorspellen, maar ook naar de dynamiek van wat voorspeld wordt. Ik heb daar onlangs al een poging toe gedaan met mijn verhaal over nut en waarde van het voorspellen van economische groei.

Normal accident theory

Vandaag wil ik kort stilstaan bij de dynamiek van een nucleair ongeluk. Ik heb ervoor gekozen om het voorbeeld van Three Mile Island te nemen, omdat ik een interessante theorie wil belichten, de normal accident theory, van socioloog Charles Perrow, die hij naar aanleiding van dit ongeluk formuleerde. Het is een theorie die veel invloed heeft gehad over het denken over risico’s in complexe systemen. De theorie heeft ook veel kritiek gekregen, maar ik denk dat het een nuttige zienswijze is, die veel actuele discussies in een ander licht kan plaatsen.

Volgens Perrow was het ongeluk in Three Mile Island een normal accident (ik hou de Engelse term aan), een ongeluk dat voortkomt uit de complexiteit van het systeem zelf en niet te voorkomen is.

Normal accidents hebben volgens Perrow vier karakteristieken. Ten eerste hebben waarschuwingssignalen maar een beperkte rol in het voorkomen of beperken van een ongeluk. In de praktijk worden waarschuwingssignalen vaak genegeerd. Zelfs directe waarschuwingen in de vorm alarmbellen of zwaailichten worden in de praktijk vaak afgedaan als triviaal, of als een technisch mankement. In scherp beveiligde omgevingen zijn valse alarmen namelijk schering en inslag.

Ook in Three Mile Island werden waarschuwingen genegeerd. Niet uit luiheid, maar de operateurs uit ervaring wisten dat een alarm tot dan toe nooit iets voorstelde.

directe waarschuwingen in de vorm alarmbellen of zwaailichten worden in de praktijk vaak afgedaan als triviaal

Complexe systemen kenmerken zich door een veelheid van onderdelen die met elkaar verbonden zijn. Dat leidt tot onverwachte interacties die zich op onvoorspelbare wijze door het systeem kunnen verplaatsen. Een niet goed schoongemaakte leiding, geeft problemen in een heel ander vitaal systeem. En het effect wordt versterkt. Iets kleins, een lekkend ventiel, kan tot grote schade schade leiden (een bijna ramp, een miljard dollar schade). En als dit soort ongelukken plaatsvinden, zijn ze grotendeels oncontroleerbaar. Ingrijpen leidt vaak tot vergerging van het probleem.

Een tweede karakteristiek is dat er ontwerpfouten in het systeem zitten. Die ontwerpfouten zijn onvermijdelijk: een perfect ontworpen kerncentrale bestaat niet. Vervelend is dat de ontwerpfouten heel klein zijn, maar door de sterke interactie met andere systemen grote gevolgen kunnen hebben. Neem het ventiel. Het lampje in het commandocentrum voor het betreffende ventiel was uit, een indicatie dat het ventiel dicht was. Wat de operateur niet wist, was dat het lampje uitging als de opdracht voor het dichtdraaien van een ventiel was verstuurd. Er werd nergens gecontroleerd of een ventiel daadwerkelijk dicht was. In dit geval dus niet. En zo waren er nog meer knulligheden, die grote gevolgen hadden. De printer ging stuk, waardoor de operateurs op basis van anderhalf uur oude data besluiten moesten nemen. ‘In normal accidents the particular trigger is relatively insignificant; the interaction is significant,’ schrijft Perrow.

Menselijk falen

Een derde karakteristiek is de faalbaarheid van de operateurs. Die kregen aanvankelijk ook alle schuld in de schoenen geschoven. Maar het personeel deed gewoon zijn werk. Three Mile Island had ongeveer tweeduizend ventielen. Het kwam geregeld voor dat er ventielen kapot waren of niet goed functioneerden. Dat leidde nooit tot problemen. Daarnaast wordt foutief handelen altijd achteraf vastgesteld. De operateurs handelden netjes volgens voorgeschreven protocollen, maar het bleek dat die protocollen op sommige punten niet klopten. Dat was nooit opgevallen want er had zich niet eerder zo’n extreme situatie voorgedaan. Daarnaast moesten de operateurs continu beslissingen nemen op basis van conflicterende informatie, omdat de apparatuur niet goed meer functioneerde.

Tot slot treedt in normal accidents het verschijnsel ‘negatieve synergie’ op. Op zichzelf staande kleine fouten in signalering, ontwerp en uitvoering leiden tot een uitkomst die veel ernstiger is dan de som der delen. Daar kun je niet voor trainen. Het systeem in zij totaliteit gedraagt zich grillig, onvoorspelbaar en is daardoor haast niet meer in de hand te houden.

Volgens Perrow is er maar een manier om met dit soort risico’s om te gaan: niet aan beginnen. Er zijn volgens hem ook goede alternatieve energiebronnen, die tezamen geen complexe organisatie en ontwerp vereisen, maar die decentraal opereren, met minimale risico’s voor werknemers en omwonenden. Normal accidents gebeuren niet vaak, maar ze komen voor. En de geschiedenis lijkt hem vooralsnog gelijk te geven.