Kunstmatige intelligentie, leg dat maar eens uit

Hoe komt kunstmatige intelligentie tot bepaalde uitkomsten? Dat is vaak onduidelijk. Onderzoeker Jelle Zuidema van de UvA wil daarom AI-systemen uitlegbaar maken. ‘Het moet duidelijk zijn waarom een systeem bepaalde keuzes maakt.’

Hans was een genie. Rond 1900 toonde hij in Duitsland op kermissen en braderieën zijn bijzondere kwaliteiten. Het was ongelooflijk hoe Hans rekenkundige dilemma’s op wist te lossen.

Ongelooflijk, voor een paard.

3 plus 4? De hengst klikte 7 keer met zijn hoeven op de grond. 8 gedeeld door 2? Hans stampte 4 keer. ‘Hans is een expert in getallen’, schreef The New York Times in 1904,* ‘en kan zelfs breuken begrijpen.’ Naast rekenen herkende Hans ook kleuren en kon hij klokkijken. ‘Hij kan bijna alles behalve praten’, volgens de krant.

Later bleek – uiteraard – dat niets minder waar was. Omdat Hans vaak goede antwoorden gaf, leek het alsof hij kon rekenen, kleuren herkennen en klokkijken. In werkelijkheid pikte Hans signalen op van de vragensteller en het publiek en wist zo wanneer hij goed zat.

In de wetenschap is dit het Kluger-Hans-effect (Slimme Hans) gaan heten: bepaald gedrag krijgt een bepaalde verklaring – Hans kan rekenen, dus Hans is slim – maar in werkelijkheid veroorzaakt iets anders dit gedrag. Hans lijkt te kunnen rekenen, maar herkent in werkelijkheid lichaamstaal.

Het Slimme-Hans-effect speelt ook in de kunstmatige intelligentie (AI), legt universitair hoofddocent Natuurlijke Taalverwerking aan de Universiteit van Amsterdam Jelle Zuidema uit, in zijn werkkamer op het Science Park in Amsterdam.

Vaak is onduidelijk hoe AI tot bepaalde uitkomsten komt. Dan doet de kunstmatige-intelligentietoepassing opeens iets heel slims – maar waarom? Het risico, legt Zuidema uit, is dat slimmigheid aan het systeem wordt toegeschreven, maar dat er iets anders speelt.

Zuidema noemt het voorbeeld van een AI-model dat heel goed lijkt te zijn in het herkennen van tumoren op radiologische foto’s. Later kan dan blijken dat de artsen de foto’s van de tumoren al hadden bekeken en deze onbedoeld een kenmerk meegaven – een vouw, een stipje met een pen.* Het AI-model slaat dan aan op dat patroon en niet op de tumor. ‘Het AI-model heeft dan eigenlijk ontdekt dat er een shortcut is,’ legt Zuidema uit. ‘Ze spelen nog weleens vals, net als Hans het paard.’

We moeten het hebben over uitlegbaarheid

Ik spreek Zuidema voor de serie gesprekken die ik voer om AI te doorgronden. Hij doet onderzoek naar taal en kunstmatige intelligentie en is specialist in large language models, grote taalmodellen zoals GPT. Ik wil van hem weten welk inzicht het debat over kunstmatige intelligentie nú nodig heeft.

Volgens Zuidema moeten we het dringend hebben over uitlegbaarheid. Hoe kan uitgelegd worden hoe een AI-toepassing tot een bepaalde uitkomst komt? Kunnen we begrijpelijk maken wat er in zo’n model gebeurt?

Dat is belangrijk nu AI-toepassingen op steeds meer plekken worden gebruikt, van de rechtspraak tot de zorg, van de journalistiek tot de politie. Die uitlegbaarheid dient burgers en consumenten die in aanraking komen met zo’n toepassing, omdat zij die beter kunnen begrijpen. En het dient de ontwikkelaars ervan: die weten in een vroeg stadium waarom het systeem doet wat het doet – zodat het nog bijgestuurd of aangepast kan worden.

Hoe doe je dat dan, begrijpelijk krijgen hoe AI werkt?

‘Voor een deel kun je AI-modellen reconstrueren. Je kunt dan leren hoe een model tot zijn beslissingen is gekomen. Maar dat is met terugwerkende kracht, je hebt dan geen invloed op het trainen van het model.’

‘Je kunt óók proberen het model zo te programmeren dat je kunt controleren hoe het tot een bepaalde oplossing komt. Zodat je bijvoorbeeld kunt zien of het model echt op de tumor is gericht en niet op een flauwe shortcut. Dat dient dan als een soort waarschuwingssignaal: we zitten hier te kijken naar het Slimme-Hans-effect en niet naar iets dat de echte oplossing heeft gevonden, namelijk het detecteren van de tumor.’

En hoe doe je dat?

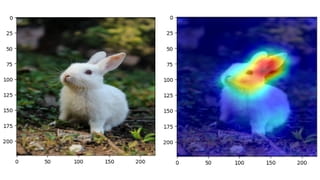

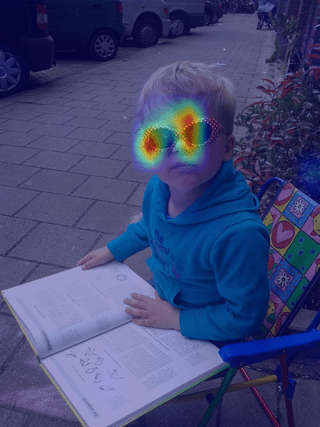

‘Daar gebruiken wij ook weer AI voor. Een van die techniekjes heet "attributie". Stel, je hebt een beeldherkenningsprogramma dat dieren herkent. Dan vragen we: wat zijn voor jou de belangrijkste pixels op een plaatje om tot het label roofvogel of konijn te komen? En als het programma dan bij een konijn niet een beetje aandacht voor de oren heeft, of bij de roofvogel niet let op de vleugels en de snavel, dan weet je dat er eigenlijk iets verkeerd is gegaan. Want hij is op een heel andere grond tot het label gekomen.’

Wanneer is die uitlegbaarheid cruciaal?

‘Als AI-toepassingen mensenlevens kunnen maken of breken. Een recent voorbeeld is een taalmodel dat gebruikt wordt om vacatureteksten en sollicitatiebrieven te lezen en te analyseren, en om uit te zoeken welke goed op elkaar aansluiten.’

‘Omdat dat zo ingrijpend kan zijn, is het niet aanvaardbaar dat de uitkomsten van zo’n systeem onuitlegbaar blijven. Maar dat betekent ook weer niet dat je alle moderne, en moeilijk uitlegbare AI overboord moet gooien. Je kunt ook een tussenstap inbouwen: je laat de onuitlegbare AI-magie los op het lezen van vacatureteksten en sollicitatiebrieven, maar zorgt ervoor dat het matchen perfect uitlegbaar is. Waarom koppelt hij deze sollicitatie aan deze vacature?’

‘Want het probleem ligt op de loer dat zo’n systeem ook shortcuts neemt zoals Slimme Hans. Bij een sollicitatieronde voor een technisch beroep kan het bijvoorbeeld zijn dat de dataset waarop je het model traint een enorme oververtegenwoordiging van mannen heeft en dat het systeem zo automatisch vrouwen uitsluit. Je wilt dan een uitlegbaar model zodat je kunt zien waarom er bepaalde keuzes worden gemaakt.’

‘Het hangt er dus van af hoe die systemen gebruikt gaan worden, maar de geeks uit de deep learning-wereld hebben weinig aandacht voor wat de technologie nou eigenlijk doet in de maatschappij.’

Waar merk je dat aan?

‘Vaak ontwerpen techneuten een AI als een systeem in isolatie, een soort autonome intelligentie die zelf beslissingen neemt. Maar dat is meestal niet hoe we AI willen gebruiken. Dat willen we doen in samenwerking met de mens. Neem bijvoorbeeld een specifieke toepassing van AI op de intensive care, waarbij AI ic-artsen helpt bij de beslissing of een patiënt ontslagen kan worden of juist niet. Uiteindelijk neemt de arts die beslissing, maar die kan wel geïnformeerd worden door dat AI-systeem. Heb ik aan alles gedacht? En dan is het dus essentieel dat er bij elk advies ook een uitgebreide uitleg geleverd wordt.’

Waarom doen ontwikkelaars en onderzoekers dit niet altijd?

‘Dit heeft geen prioriteit door de enorme competitiecultuur in ons vakgebied. Je wordt eigenlijk niet serieus genomen als je niet kunt laten zien dat je beter scoort dan de concurrentie op een bepaalde kwantificeerbare standaard.’

‘Uiteindelijk wordt daarmee alles teruggebracht tot één getal dat moet uitdrukken hoe goed je systeem is en meestal komt dat neer op: hoeveel fouten maakt het? Maar het is gevaarlijk om je blind te staren op één aspect van het systeem. Want al die andere dingen die ook belangrijk zijn delven dan het onderspit. Het gaat niet alleen om hoeveel procent goed of fout is, maar ook om moeilijker te meten zaken. Zoals die uitlegbaarheid, maar ook bijvoorbeeld hoeveel rekenkracht er nodig is, hoeveel energie daarbij is gebruikt, hoe de dataset tot stand is gekomen en hoe de werknemers die data labelen behandeld zijn.’

‘Het is een beetje vergelijkbaar met economen die het alleen maar over het bbp hebben. Andere factoren zoals het milieu worden dan verwaarloosd.’

Is het voorstelbaar dat er een bepaald AI-systeem is dat fundamenteel niet uitlegbaar is en dat dus afgeschaft moet worden?

‘Er is altijd de theoretische mogelijkheid dat iets fundamenteel niet uitlegbaar is. Dat ontslaat je niet van de plicht om het wel eerst serieus te proberen, maar als het echt niet lukt, dan moet je misschien concluderen: hier gebruiken we geen AI voor. Als het gaat over zaken die de bestaanszekerheid van mensen raken dan is het moeilijk te verkopen als je mensen niet individueel uitleg kunt geven, en alleen wat statistieken kunt overhandigen. Zo van, oké, jij hebt de baan, de uitkering of de verzekering wéér niet gekregen. We kunnen je alleen niet vertellen waarom. Maar wees gerust, gemiddeld discrimineert de computer niet. Dát is pas echt niet uit te leggen.’